Série de artigos sobre Instalação do Oracle RAC:

Instalação do Oracle RAC 10g Release 2 – Parte 1: Pré-requisitos

Instalação do Oracle RAC 10g Release 2 – Parte 2: Criação da VM

Instalação do Oracle RAC 10g Release 2 – Parte 3: Instalação do Linux

Instalação do Oracle RAC 10g Release 2 – Parte 4: Configuração do Linux

Instalação do Oracle RAC 10g Release 2 – Parte 5: Clonagem da VM

Instalação do Oracle RAC 10g Release 2 – Parte 6: Pré-instalação do RAC

===================================

Olá pessoal!

Nesse artigo instalaremos o Oracle Clusterware 10.2.0.1. Com isso, já subiremos no sistema operacional dos servidores mvrac1 e mvrac2 a camada de cluster necessária para a criação de um banco de dados Oracle RAC. Alguns pontos importantes:

- A instalação do Oracle Home será local, ou seja, cada servidor terá uma cópia do Oracle Home;

- Cada servidor precisa de pelo menos duas placas de rede:

- Rede Pública: para subir o endereço IP Virtual, o chamado VIP;

- Rede Privada: para subir o endereço IP da rede privada entre os nós, o chamado InterConnect.

- Precisamos de discos compartilhados entre os servidores:

- Armazenamento do OCR;

- Armazenamento do Voting Disk;

- Discos ASM.

- Os usuários oracle de cada servidor precisarão ter equivalência de usuário entre si.

Bom, vamos lá?

Na tela da VMWare Server Console, deveremos clicar duas vezes no ícone do CD-ROM (identificado pela seta vermelha).

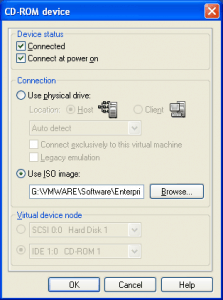

Eu fiz uma imagem ISO com alguns softwares Oracle, portanto, na tela acima, deveremos manter a opção “Use ISO image:” marcada, e clicar em Browse, para escolhermos a mídia do Oracle:

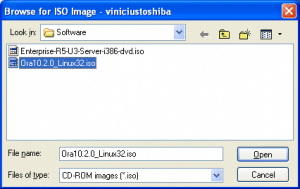

Basta selecionar a imagem ISO, e clicar em Open.

Agora, precisamos montar esse CD no servidor. Como root no servidor mvrac1:

[root@mvrac1 ~]# mount /dev/hdc /media mount: block device /dev/hdc is write-protected, mounting read-only

Para verificar se o disco foi montado:

[root@mvrac1 ~]# df -h Filesystem Size Used Avail Use% Mounted on /dev/sda1 11G 2.4G 7.8G 24% / tmpfs 252M 0 252M 0% /dev/shm /dev/hdc 3.1G 3.1G 0 100% /media

Com o disco montado, precisamos acessá-lo:

[root@mvrac1 ~]# cd /media/Ora10.2.0.1

Vamos ver o conteúdo do disco:

[root@mvrac1 Ora10.2.0.1]# ls -l total 8 dr-xr-xr-x 6 root root 2048 May 21 2008 client dr-xr-xr-x 9 root root 2048 May 21 2008 clusterware dr-xr-xr-x 6 root root 2048 May 21 2008 companion dr-xr-xr-x 6 root root 2048 May 21 2008 database

Agora copiaremos o diretório clusterware para o diretório /home/oracle:

[root@mvrac1 Ora10.2.0.1]# cp -rp clusterware/ /home/oracle/

Agora precisamos acertar as permissões, pois o diretório foi copiado como root:

[root@mvrac1 ~]# chown -R oracle:oinstall /home/oracle/*

Agora, iniciaremos a instalação. Há algumas formas de realizar a instalação:

- Localmente no servidor, através da VMWare Server Console;

- Remotamente, através de um software que simule um X-Server (existem diversas opções gratuitas na Internet);

- Remotamente, através de uma estação Linux/Unix/Mac que tenha a parte gráfica (X) habilitado.

Eu usarei a terceira opção, portanto, a partir da minha estação:

vinicius@Viniciuss-MacBook:~$ ssh -X oracle@172.23.10.11 oracle@172.23.10.11's password: /usr/bin/xauth: creating new authority file /home/oracle/.Xauthority

Testando para ver se a parte gráfica está funcionando:

[oracle@mvrac1 ~]$ xclock

O teste funcionou! Vejam:

Bom, apenas para facilitar a instalação, vamos definir algumas variáveis de ambiente, já colocando-as no arquivo .bash_profile:

[oracle@mvrac1 ~]$ vi .bash_profile

O conteúdo do arquivo deverá ter o seguinte:

# .bash_profile

# Get the aliases and functions

if [ -f ~/.bashrc ]; then

. ~/.bashrc

fi

export ORACLE_BASE=/u01/app/oracle

export ORA_CRS_HOME=${ORACLE_BASE}/product/10.2.0/crs

export ORACLE_HOME=${ORACLE_BASE}/product/10.2.0/db_1

export PATH=${ORA_CRS_HOME}/bin:${ORACLE_HOME}/bin:/usr/kerberos/bin:/usr/local/bin:/bin:/usr/bin:/usr/sbin:/sbin

Com o arquivo configurado, devemos fechar o vi e salvá-lo.

Após isso, devemos carregar as variáveis de ambiente:

[oracle@mvrac1 ~]$ . .bash_profile

Para confirmar se as variáveis foram carregadas:

[oracle@mvrac1 ~]$ env |grep ORA ORA_CRS_HOME=/u01/app/oracle/product/10.2.0/crs ORACLE_BASE=/u01/app/oracle ORACLE_HOME=/u01/app/oracle/product/10.2.0/db_1

Pronto!

Vamos iniciar a instalação:

[oracle@mvrac1 ~]$ cd clusterware/ [oracle@mvrac1 clusterware]$ ls -l total 36 dr-xr-xr-x 2 oracle oinstall 4096 May 21 2008 cluvfy dr-xr-xr-x 6 oracle oinstall 4096 May 21 2008 doc dr-xr-xr-x 4 oracle oinstall 4096 May 21 2008 install dr-xr-xr-x 2 oracle oinstall 4096 May 21 2008 response dr-xr-xr-x 2 oracle oinstall 4096 May 21 2008 rpm -r-xr-xr-x 1 oracle oinstall 1328 Jul 2 2005 runInstaller dr-xr-xr-x 9 oracle oinstall 4096 May 21 2008 stage dr-xr-xr-x 2 oracle oinstall 4096 May 21 2008 upgrade -r--r--r-- 1 oracle oinstall 3445 Jul 2 2005 welcome.html

Como estamos usando o RHEL5/OEL5, quando o produto 10.2.0.1 foi lançado, essa versão de sistema operacional ainda não estava disponível no mercado, precisaremos executar a instalação informando que a verificação de pré-requisitos deverá ser ignorada:

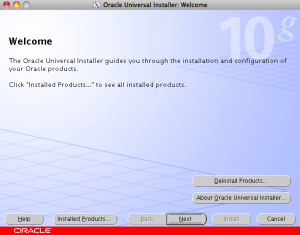

[oracle@mvrac1 clusterware]$ ./runInstaller -ignoreSysPreReqs

A tela acima é a tela inicial. Devemos clicar em Next:

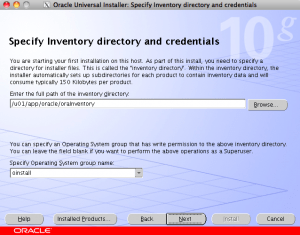

A tela acima solicita definirmos a localização do inventário e qual será o grupo no sistema operacional que será o dono do inventário. Os valores sugeridos serão:

- Para a localização do inventário: /u01/app/oracle/oraInventory;

- Para o grupo do sistema operacional: oinstall.

Clicar em Next:

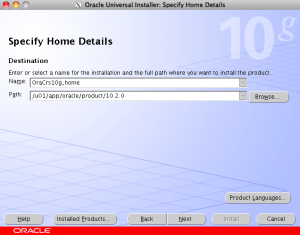

Na tela acima devemos especificar o nome do Oracle Home do Clusterware, assim como a sua localização. Os valores sugeridos são:

- Para o nome do Oracle Home do Clusterware: OraCrs10g_home;

- Para a localização do Oracle Home do Clusterware: /u01/app/oracle/product/10.2.0/crs.

Clicar em Next:

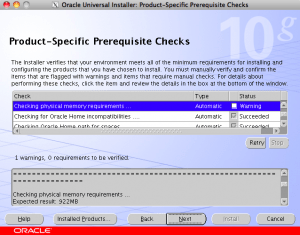

O OUI reclamará de pouca memória, bastará clicar na caixa de seleção onde está escrito “Warning” na coluna de Status:

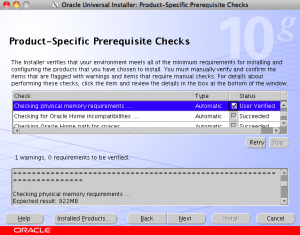

Após ter clicado na caixa, observem que o status passará para o valor “User Verified”. Clicar em Next:

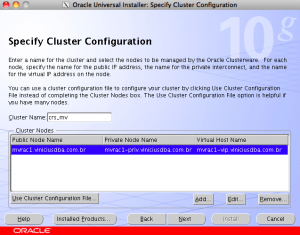

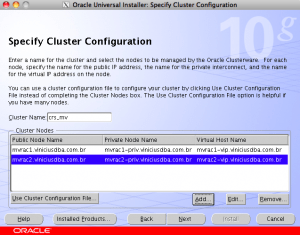

Na tela acima, devemos especificar a configuração do cluster. O campo “Cluster Name” deve ter valor único na rede corporativa. O nome default é “crs”. Eu alterei o valor para “crs_mv”. Observem que no campo “Cluster Nodes” as informações de “Public Node Name”,”Private Node Name” e “Virtual Host Name” já aparecerão para o host mvrac1, já que a instalação foi iniciada a partir desse host. Como o cluster terá 2 nós, precisamos adicionar mais um nó na configuração do cluster. Basta clicar no botão “Add”:

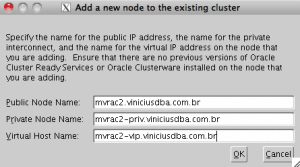

Deveremos preencher os campos “Public Node Name”, “Private Node Name” e “Virtual Host Name”. Os valores sugeridos são:

- Para o “Public Node Name”: mvrac2.viniciusdba.com.br;

- Para o “Private Node Name”: mvrac2-priv.viniciusdba.com.br;

- Para o “Virtual Node Name”: mvrac2-vip.viniciusdba.com.br.

Clicar em OK:

Observem que agora na tela são exibidos os 2 nós. Ao clicar em Next, o OUI verificará 2 itens:

- Se os hostnames informados existem no arquivo /etc/hosts;

- Se há equivalência de usuário entre os nós especificados para o usuário oracle.

Apenas para lembrarmos do /etc/hosts:

# ============================================================ # Arquivo /etc/hosts configurado para utilizacao do Oracle RAC # Configurado por Marcus Vinicius # 18/02/2010 # ============================================================ # Localhost 127.0.0.1 localhost.localdomain localhost # Oracle RAC 10g #----------------- # Rede Publica 172.23.10.11 mvrac1.viniciusdba.com.br mvrac1 172.23.10.12 mvrac2.viniciusdba.com.br mvrac2 # InterConnect - Conexao Privada 10.0.0.11 mvrac1-priv.viniciusdba.com.br mvrac1-priv 10.0.0.12 mvrac2-priv.viniciusdba.com.br mvrac2-priv # Virtual IP's 172.23.10.21 mvrac1-vip.viniciusdba.com.br mvrac1-vip 172.23.10.22 mvrac2-vip.viniciusdba.com.br mvrac2-vip

Clicar em Next:

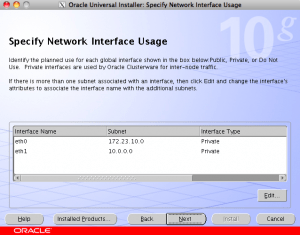

Na tela acima serão exibidas TODAS as interfaces de rede existentes no servidor. A regra que utilizaremos será:

- eth0: Pública;

- eth1: Privada.

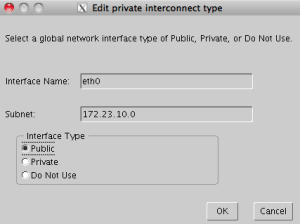

Mas, observem que as duas interfaces aparecem como Privadas. Nesse caso, deveremos selecionar a interface eth0 e clicar no botão Edit:

Basta clicar na opção “Option” e depois clicar em OK. Caso tivéssemos mais de duas placas de rede, deveríamos selecionar a placa que não seria usada no cluster, e selecionar a opção “Do not use”.

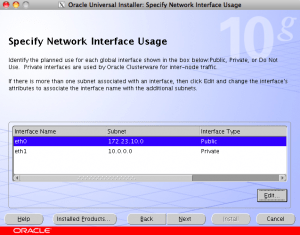

Após editarmos a placa de rede eth0, agora sim observaremos que as duas placas estão com as configurações adequadas. Clicar em Next:

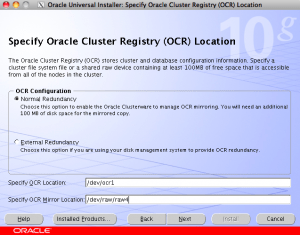

Na tela acima, deveremos especificar o tipo de redundância para o OCR: normal (2 locais), externa (1 local). O tipo de redundância escolhido foi a normal. Após isso, deveremos especificar 2 locais para armazenar o OCR. Lembram que eu comentei que o OUI do Clusterware 10.2.0.1 não consegue determinar se os block devices estão compartilhados entre os nós do cluster? Pois bem, eu simulei o erro e especifiquei um local apontando para um block device, e outro apontando para um raw device:

- OCR Location: /dev/ocr1 (block device);

- OCR Mirror Location: /dev/raw/raw4 (raw device).

Clicar em Next:

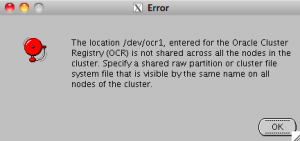

A tela acima será exibida com a mensagem informando que a localização /dev/ocr1 não está compartilhada entre os nós do cluster. Isso é descrito na Nota do Metalink número 401132.1. Clicar em OK:

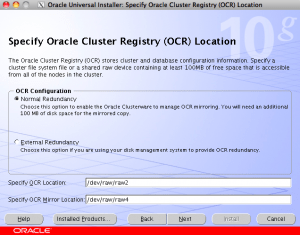

Devemos corrigir o valor para o campo “Specify OCR Location”. Os dois campos deverão estar preenchidos da seguinte forma:

- OCR Location: /dev/raw/raw2;

- OCR Mirror Location: /dev/raw/raw4.

Clicar em Next:

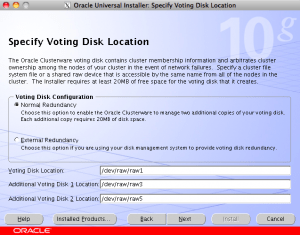

Na tela acima, deveremos especificar o tipo de redundância e localização do voting disk. O tipo de redundância escolhido foi o normal. A localização dos voting disks deverá ser o seguinte:

- Voting Disk Location: /dev/raw/raw1;

- Additional Voting Disk 1 Location: /dev/raw/raw3;

- Additional Voting Disk 2 Location: /dev/raw/raw5.

Clicar em Next:

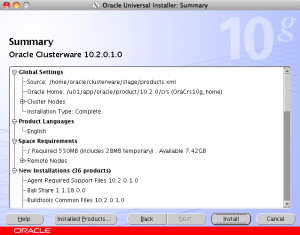

Um resumo sobre a instalação será exibido. Clicar em Install:

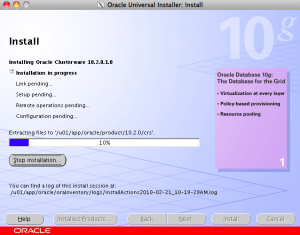

A janela com o progresso da instalação será exibida. Observem que há um item chamado “Remote operations pending”. É nesse item que o Oracle Home será copiado para o outro nó.

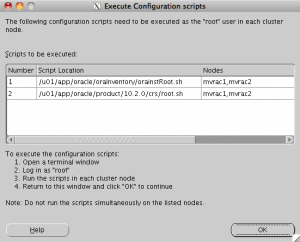

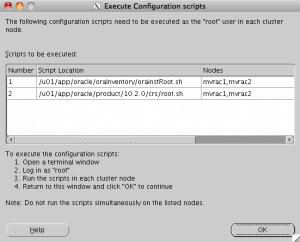

Uma janela aparecerá solicitando executarmos scripts como root nos 2 nós do cluster. Não podemos executar os scripts em paralelo!! Devemos executar os scripts no primeiro nó, e depois, no segundo nó.

Vamos à execução do script /u01/app/oracle/oraInventory/orainstRoot.sh no nó mvrac1:

[root@mvrac1 ~]# /u01/app/oracle/oraInventory/orainstRoot.sh Changing permissions of /u01/app/oracle/oraInventory to 770. Changing groupname of /u01/app/oracle/oraInventory to oinstall. The execution of the script is complete

Agora, vamos executar o script /u01/app/oracle/product/10.2.0/crs/root.sh no nó mvrac1:

[root@mvrac1 ~]# /u01/app/oracle/product/10.2.0/crs/root.sh WARNING: directory '/u01/app/oracle/product/10.2.0' is not owned by root WARNING: directory '/u01/app/oracle/product' is not owned by root WARNING: directory '/u01/app/oracle' is not owned by root WARNING: directory '/u01/app' is not owned by root WARNING: directory '/u01' is not owned by root Checking to see if Oracle CRS stack is already configured /etc/oracle does not exist. Creating it now. Setting the permissions on OCR backup directory Setting up NS directories Oracle Cluster Registry configuration upgraded successfully WARNING: directory '/u01/app/oracle/product/10.2.0' is not owned by root WARNING: directory '/u01/app/oracle/product' is not owned by root WARNING: directory '/u01/app/oracle' is not owned by root WARNING: directory '/u01/app' is not owned by root WARNING: directory '/u01' is not owned by root assigning default hostname mvrac1 for node 1. assigning default hostname mvrac2 for node 2. Successfully accumulated necessary OCR keys. Using ports: CSS=49895 CRS=49896 EVMC=49898 and EVMR=49897. node : node 1: mvrac1 mvrac1-priv mvrac1 node 2: mvrac2 mvrac2-priv mvrac2 Creating OCR keys for user 'root', privgrp 'root'.. Operation successful. Now formatting voting device: /dev/raw/raw1 Now formatting voting device: /dev/raw/raw3 Now formatting voting device: /dev/raw/raw5 Format of 3 voting devices complete. Startup will be queued to init within 90 seconds. Adding daemons to inittab Expecting the CRS daemons to be up within 600 seconds. CSS is active on these nodes. mvrac1 CSS is inactive on these nodes. mvrac2 Local node checking complete. Run root.sh on remaining nodes to start CRS daemons.

Após a conclusão desse script, vamos executar o script /u01/app/oraInventory/orainstRoot.sh no nó mvrac2:

[root@mvrac2 ~]# /u01/app/oracle/oraInventory/orainstRoot.sh Changing permissions of /u01/app/oracle/oraInventory to 770. Changing groupname of /u01/app/oracle/oraInventory to oinstall. The execution of the script is complete

Em seguida, devemos executar o script /u01/app/oracle/product/10.2.0/crs/root.sh no nó mvrac2:

[root@mvrac2 ~]# /u01/app/oracle/product/10.2.0/crs/root.sh WARNING: directory '/u01/app/oracle/product/10.2.0' is not owned by root WARNING: directory '/u01/app/oracle/product' is not owned by root WARNING: directory '/u01/app/oracle' is not owned by root WARNING: directory '/u01/app' is not owned by root WARNING: directory '/u01' is not owned by root Checking to see if Oracle CRS stack is already configured /etc/oracle does not exist. Creating it now. Setting the permissions on OCR backup directory Setting up NS directories Oracle Cluster Registry configuration upgraded successfully WARNING: directory '/u01/app/oracle/product/10.2.0' is not owned by root WARNING: directory '/u01/app/oracle/product' is not owned by root WARNING: directory '/u01/app/oracle' is not owned by root WARNING: directory '/u01/app' is not owned by root WARNING: directory '/u01' is not owned by root clscfg: EXISTING configuration version 3 detected. clscfg: version 3 is 10G Release 2. assigning default hostname mvrac1 for node 1. assigning default hostname mvrac2 for node 2. Successfully accumulated necessary OCR keys. Using ports: CSS=49895 CRS=49896 EVMC=49898 and EVMR=49897. node : node 1: mvrac1 mvrac1-priv mvrac1 node 2: mvrac2 mvrac2-priv mvrac2 clscfg: Arguments check out successfully. NO KEYS WERE WRITTEN. Supply -force parameter to override. -force is destructive and will destroy any previous cluster configuration. Oracle Cluster Registry for cluster has already been initialized Startup will be queued to init within 90 seconds. Adding daemons to inittab Expecting the CRS daemons to be up within 600 seconds. CSS is active on these nodes. mvrac1 mvrac2 CSS is active on all nodes. Waiting for the Oracle CRSD and EVMD to start Waiting for the Oracle CRSD and EVMD to start Waiting for the Oracle CRSD and EVMD to start Oracle CRS stack installed and running under init(1M) Running vipca(silent) for configuring nodeapps /u01/app/oracle/product/10.2.0/crs/jdk/jre//bin/java: error while loading shared libraries: libpthread.so.0: cannot open shared object file: No such file or directory

Terminamos de executar o script, mas observem que pegamos um erro na execução do último script no nó mvrac2:

Running vipca(silent) for configuring nodeapps /u01/app/oracle/product/10.2.0/crs/jdk/jre//bin/java: error while loading shared libraries: libpthread.so.0: cannot open shared object file: No such file or directory

Esse erro é normal no Red Hat Enterprise Linux 5 e sempre acontecerá nessa versão e é descrito pela Nota do Metalink número 414163.1. Deveremos editar 2 arquivos para corrigir esse problema. Primeiro, precisamos ir para ao diretório $ORA_CRS_HOME com o usuário oracle:

[oracle@mvrac1 clusterware]$ cd $ORA_CRS_HOME/bin

Em seguida, editaremos o arquivo srvctl:

[oracle@mvrac1 bin]$ vi srvctl

Aproximadamente da linha 166, haverá a seguinte string:

#Remove this workaround when the bug 3937317 is fixed LD_ASSUME_KERNEL=2.4.19 export LD_ASSUME_KERNEL

Devemos acrescentar o seguinte conteúdo abaixo da última linha da string:

unset LD_ASSUME_KERNEL

Deverá ficar da seguinte forma:

#Remove this workaround when the bug 3937317 is fixed LD_ASSUME_KERNEL=2.4.19 export LD_ASSUME_KERNEL unset LD_ASSUME_KERNEL

Agora, editaremos o arquivo vipca:

[oracle@mvrac1 bin]$ vi vipca

Aproximadamente da linha 121, haverá a seguinte string:

#Remove this workaround when the bug 3937317 is fixed

arch=`uname -m`

if [ "$arch" = "i686" -o "$arch" = "ia64" ]

then

LD_ASSUME_KERNEL=2.4.19

export LD_ASSUME_KERNEL

fi

#End workaround

Devemos acrescentar o seguinte conteúdo abaixo da linha que tenha a string “export LD_ASSUME_KERNEL”:

unset LD_ASSUME_KERNEL

Deverá ficar da seguinte forma:

#Remove this workaround when the bug 3937317 is fixed

arch=`uname -m`

if [ "$arch" = "i686" -o "$arch" = "ia64" ]

then

LD_ASSUME_KERNEL=2.4.19

export LD_ASSUME_KERNEL

unset LD_ASSUME_KERNEL

fi

#End workaround

Feito isso, deveremos copiar esses dois arquivos para o servidor mvrac2:

[oracle@mvrac1 bin]$ scp -rp srvctl mvrac2:`pwd` srvctl 100% 5577 5.5KB/s 00:00 [oracle@mvrac1 bin]$ scp -rp vipca mvrac2:`pwd` vipca 100% 5038 4.9KB/s 00:00

Podemos agora voltar para tela de instalação e clicar no botão OK:

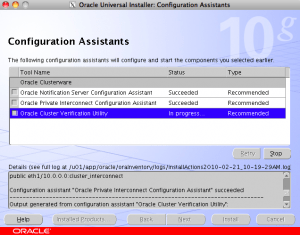

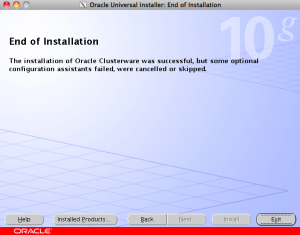

Uma janela será exibida com a execução automática de assistentes de configuração:

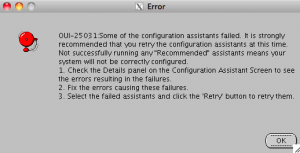

No último assistente (Oracle Cluster Verification Utility), teremos um erro:

Erro erro é comum e não devemos nos preocupar. Clicar em OK:

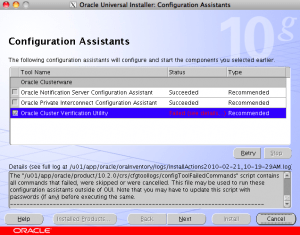

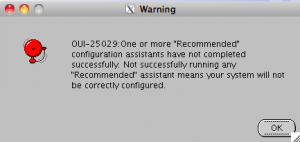

Será exibido na janela que o último assistente falhou. Clicar em Next. Aparecerá uma mensagem informando que um assistente falhou:

Clicar em OK:

Clicar em Exit:

Clicar em Yes.

Estamos quase finalizando a instalação do Clusterware. Lembrem-se que na execução do último script no servidor mvrac2, obtivemos um erro:

Running vipca(silent) for configuring nodeapps /u01/app/oracle/product/10.2.0/crs/jdk/jre//bin/java: error while loading shared libraries: libpthread.so.0: cannot open shared object file: No such file or directory

Pois bem, o assistente VIPCA, responsável por criar os recursos de IP virtuais (os VIP’s), nos servidores, falhou. Agora que corrigimos o problema editando os arquivos srvctl e vipca, agora precisamos executar o assistente vipca para criarmos os IP’s virtuais. No entanto, como se trata de iniciar um endereço IP no sistema operacional, só é possível executar o vipca com o usuário root (e com display gráfico):

vinicius@Viniciuss-MacBook:~$ ssh -X root@172.23.10.11 root@172.23.10.11's password: Last login: Sun Feb 21 09:35:58 2010 from 172.23.10.100

[root@mvrac1 ~]# /u01/app/oracle/product/10.2.0/crs/bin/vipca

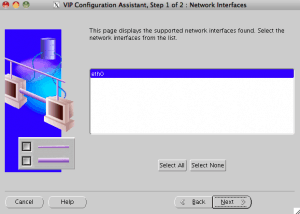

A tela inicial do VIPCA será exibida. Clicar em Next:

A interface de rede eth0 será exibida. Foi essa interface que definimos como interface de rede pública na instalação do Oracle Clusterware. Clicar em Next:

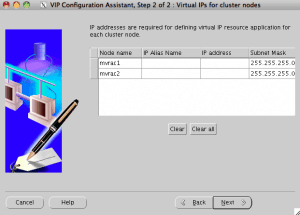

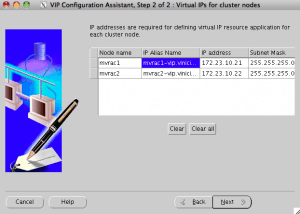

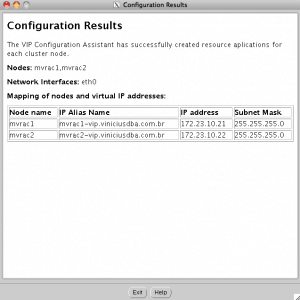

A janela acima será exibida. Precisamos definir o “IP Alias Name” para os servidores. Basta preencher o valor para o servidor mvrac1:

- mvrac1-vip.viniciusdba.com.br

Pressionar [TAB] e o valor para o servidor mvrac2 será preenchido automaticamente, através da leitura do arquivo /etc/hosts:

Clicar em Next:

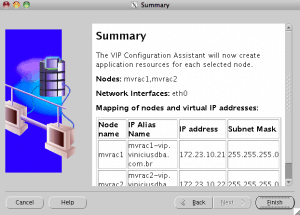

Um resumo sobre a configuração será exibido. Clicar em Finish.

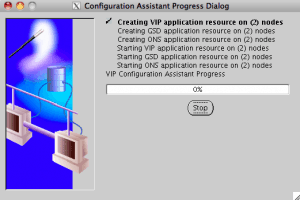

Uma janela com o progresso da operação será exibido. Aguardar.

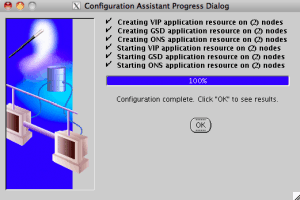

Quando o processo terminar, clicar no botão OK.

Uma janela com o resultado da configuração será exibido. Nesse momento, os endereços IP virtuais estarão online em cada servidor. Clicar em Exit.

Com o usuário oracle mesmo, podemos verificar quais são os endereços IP que estão online no servidor mvrac1:

[oracle@mvrac1 ~]$ ifconfig |grep inet | grep -v fe | grep -v 127.0. | grep -v ::1/128

inet addr:172.23.10.11 Bcast:172.23.10.255 Mask:255.255.255.0

inet addr:172.23.10.21 Bcast:172.23.10.255 Mask:255.255.255.0

inet addr:10.0.0.11 Bcast:10.255.255.255 Mask:255.0.0.0

Ou seja:

- 172.23.10.11: IP público físico;

- 172.23.10.21: IP público virtual;

- 10.0.0.11: IP privado físico, InterConnect.

Vamos ver agora no servidor mvrac2:

[oracle@mvrac2 ~]$ ifconfig |grep inet | grep -v fe | grep -v 127.0. | grep -v ::1/128

inet addr:172.23.10.12 Bcast:172.23.10.255 Mask:255.255.255.0

inet addr:172.23.10.22 Bcast:172.23.10.255 Mask:255.255.255.0

inet addr:10.0.0.12 Bcast:10.255.255.255 Mask:255.0.0.0

Ou seja:

- 172.23.10.12: IP público físico;

- 172.23.10.22: IP público virtual;

- 10.0.0.12: IP privado físico, InterConnect.

Caso o servidor mvrac1 sofra algum problema de hardware ou software e seja desligado, o seu IP virtual, 172.23.10.21 será transferido automaticamente para o servidor mvrac2.

Para verificarmos o status dos recursos do cluster, com o usuário oracle:

[oracle@mvrac1 ~]$ crs_stat -t Name Type Target State Host ------------------------------------------------------------ ora.mvrac1.gsd application ONLINE ONLINE mvrac1 ora.mvrac1.ons application ONLINE ONLINE mvrac1 ora.mvrac1.vip application ONLINE ONLINE mvrac1 ora.mvrac2.gsd application ONLINE ONLINE mvrac2 ora.mvrac2.ons application ONLINE ONLINE mvrac2 ora.mvrac2.vip application ONLINE ONLINE mvrac2

Num artigo conveniente, veremos o que é cada um desses recursos. O que importa por enquanto, é que todos estão online.

Pessoal, por enquanto é isso!

No próximo artigo veremos como aplicar o patchset 10.2.0.4 no Clusterware, e também como migrar o OCR e Voting Disk para os block devices.

Um abraço!

Vinicius

Related posts

19 Comments

Deixe um comentário Cancelar resposta

Esse site utiliza o Akismet para reduzir spam. Aprenda como seus dados de comentários são processados.

Sobre

Disclaimer

Minhas postagens refletem minhas próprias opiniões e não representam necessariamente as opiniões do meu empregador, a Accenture.

Documentação que precisava pra estudar e apreder RAC.

Vou tentar estudar por ela, valeu o tutorial/passo-a-passo.

Obrigado Thierry!

Abraço!

[…] 5: Clonagem da VM Instalação do Oracle RAC 10g Release 2 – Parte 6: Pré-instalação do RAC Instalação do Oracle RAC 10g Release 2 – Parte 7: Instalação do Oracle Clusterware Instalação do Oracle RAC 10g Release 2 – Parte 8: Instalação do Patchset 10.2.0.4 no […]

[…] 5: Clonagem da VM Instalação do Oracle RAC 10g Release 2 – Parte 6: Pré-instalação do RAC Instalação do Oracle RAC 10g Release 2 – Parte 7: Instalação do Oracle Clusterware Instalação do Oracle RAC 10g Release 2 – Parte 8: Instalação do Patchset 10.2.0.4 no […]

[…] 5: Clonagem da VM Instalação do Oracle RAC 10g Release 2 – Parte 6: Pré-instalação do RAC Instalação do Oracle RAC 10g Release 2 – Parte 7: Instalação do Oracle Clusterware Instalação do Oracle RAC 10g Release 2 – Parte 8: Instalação do Patchset 10.2.0.4 no […]

[…] 5: Clonagem da VM Instalação do Oracle RAC 10g Release 2 – Parte 6: Pré-instalação do RAC Instalação do Oracle RAC 10g Release 2 – Parte 7: Instalação do Oracle Clusterware Instalação do Oracle RAC 10g Release 2 – Parte 8: Instalação do Patchset 10.2.0.4 no […]

Algo estranho na informação dos discos de OCR. Bastava mapear os discos em raw por exemplo /etc/udev/rules.d/oracle-raw.rules e atribuir as permissões e pronto. Logo a versão 10.2.0.1.0 instala o clusterware sem nenhum erro.

Ricardo, não há nada de estranho. Citei no blog que o uso de raw devices foi depreciado no Kernel 2.6.x, portanto, o uso de block devices se faz necessário. No 11g Release 1, a instalação de OCR em raw device não é mais suportada. Mas, em block devices é.

Olá Vinicius,

Já tentei algumas vezes fazer o mesmo processo que vc descreve aqui, porém assim que termina de rodar os scripts, não consigo nem a acessar o vipca que as VMs resetam sozinhas. Depois de resetadas, o vipca diz que os serviços não estão no ar.

A maquina tem 3G de memória e cada VM tem 1G de Ram. Não chega nem a alocar 2G total pra isso acontecer. Vc tem alguma dica de o que pode ser?

Se precisar de mais info pra fazer uma análise, posso te mandar em PVT se puder me dar uma mão aí.

Um abraço e obrigado desde já.

Alexander

Olá Alexander,

Eu lhe enviei um email, você recebeu?

Valeu Vini belo post, perfeito sem nenhum erro.

Abraços e parabens pelo ótimo trabalho.

Fala João, muito obrigado pelas palavras, cara!!! Abraço!

Boa tarde Vinicius.

Estou começando meus estudos em RAC e primeiramente gostaria de parabeniza-lo pelo post.

Porém ao executar a instalação do Oracle clusterware estou tendo algumas dificuldades e apresentando alguns erros. Já revisei tudo e segui seus passos detalhadamente.

O estranho é que no ponto onde você sita o erro (do vipca no segundo nó, note Metalink 414163.1) no meu ambiente não apresenta esta erro (estou usando o RH 5.3 32bit).

Continuando a instalação no Assistente de configuração você comenta um erro comum que acontece no (Oracle Cluster Verification Utility), no meu caso já apresenta falha na primeira opção (Oracle Notification Server Configuration Assistent).

Verificando o log vi que o erro aparece na momento que ele executa o seguinte comando:

[oracle@rac1 cfgtoollogs]$ /u01/app/oracle/product/10.2.0/crs/bin/oifcfg setif -global eth0/10.11.0.0:public eth1/10.0.0.0:cluster_interconnect

PRIF-10: failed to initialize the cluster registry

Abração.

Olá Renato, tudo bem?

Obrigado pela presença no blog!

O ambiente que você montou é virtual ou físico?

Zere os devices de OCR e Voting Disk, apague a instalação e tente fazer novamente a instalação.

Já peguei problemas como o seu mas onde o OCR e Voting Disk usavam multipath nativo do Linux e com isso pegava este problema.

Veja essa nota, pode te ajudar:

How to Clean Up After a Failed 10g or 11.1 Oracle Clusterware Installation [ID 239998.1]

Abraço!

Vinicius

Ótimo site, parabéns!

Obrigado!

Abraços

Vinicius, primeiramente parabéns pelo post. De fato é difícil encontrar uma documentação dessas na web !

Estou configurando um ambiente de testes para implementar o RAC em uma ambiente de produção (EE 10.2.0.1.0), porém não consigo encontrar o clusterware 10g para download.

A pergunta é, se há algum problema em instalar o clusterware 11g para trabalhar com o banco no release que tenho hoje (ou com o 10.2.0.4).

Desde já agradeço a atenção.

[]’s

Cristiano,

Obrigado pela presença no blog, mesmo ele tendo ficado abandonado! 🙂

Realmente não será mais possível instalar o 10g pois não é mais suportado. Desta forma, pode sim instalar o Clusterware 11gR1 e brincar com o Database 10g.

Grande abraço!

Vinicius

Vinícios, estou estudando RAC e peguei esse tutorial para fazer um teste.

Estou tendo um problema em chamar o vipca, será que você pode me dar uma dica?

Error: no `client’ JVM at `/u01/app/oracle/oracle/product/10.2.0/crs/jdk/jre/lib/i386/client/libjvm.so’.

Verifiquei que o diretório ‘client’ não existe onde informado. Dentro do diretório i386 só existem arquivos, mas nenhum diretório.